Richtig ist: Performante RAG Systeme und Open-Weights Reasoning LLMs können bestens auf eigener Hardware betrieben werden. Durch den Zugriff auf das lokale eigene Wissen der Organisation werden die

Ergebnisse deutlich nützlicher als bei generischen ChatGPT Anfragen.

Richtig ist: Entsprechende Hardware ist ab wenigen Hundert Euro verfügbar und kann schnell in vorhandene Server integriert werden. Dank etablierten Open Source Lösungen kommt es zu keinen laufenden Lizenzkosten.

Ihre Daten bleiben auf Ihrer eigenen Infrastruktur. Das erspart Kopfzerbrechen über die Sicherheit kritischer Informationen und personenbezogener Daten - und juristische Schwierigkeiten.

KI-Systemen auf eigener Infrastruktur kann bedenkenlos Zugriff auf interne Dokumente und Daten gegeben werden. So lassen sich Tasks mit wenigen Klicks automatisiert erledigen.

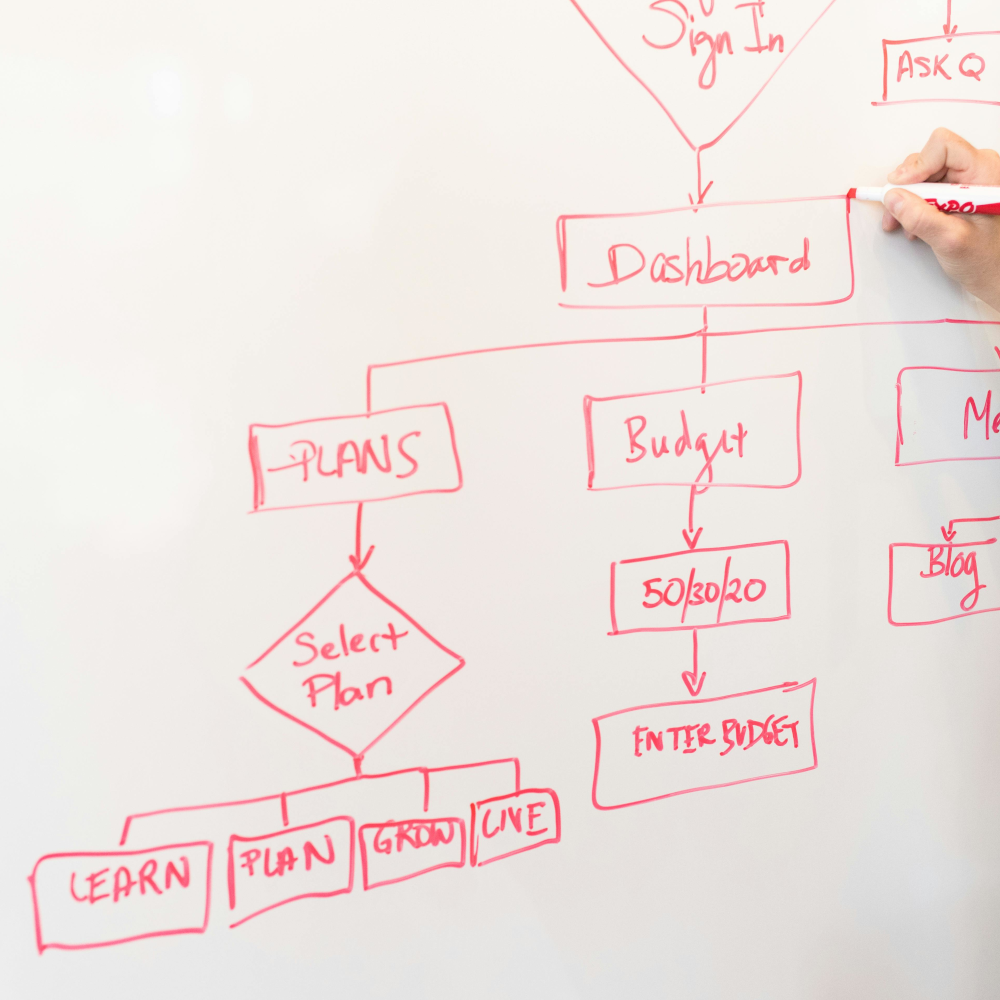

Jenseits generischer Lösungen lassen sich lokale LLMs tief in Ihre spezifischen Geschäftsprozesse integrieren.

Bis hin zu automatisierten agentischen Workflows.

Kosten pro User: 0€.

Dank Open Source Lösungen zahlen Sie keinerlei laufende Kosten für Lizenzen etc.

Skalieren Sie auf so viele User wie Sie möchten.

Kein Zugriff von außen. Keine Abhängigkeit von Herstellern oder bei externen Ausfällen.

Open Source Lösungen können exakt an die Bedürfnisse der Organisation angepasst werden.

Langfristige und regelmäßige Updates von Software und KI-Modellen dank riesiger Open Source Community.

Keine Kosten für Software, Lizenzen, APIs, oder User dank etablierten Open Source Lösungen.